En julio alertamos de un tipo de phishing tan sofisticado que, si el usuario no prestaba atención y sabía de tecnología, iba a acabar “picando”. Se trataba de un SMS de Google que no era lo que parecía. Lo último vuelve a tener a la compañía como actor principal, aunque con una variante: hacer que su IA nos engañe.

La era de las estafas con IA. El caso de Alex Rivlin, empresario de Las Vegas que preparaba unas vacaciones en Europa, se ha convertido en un ejemplo paradigmático de cómo la inteligencia artificial está siendo utilizada para actualizar métodos de estafa tradicionales con una eficacia preocupante.

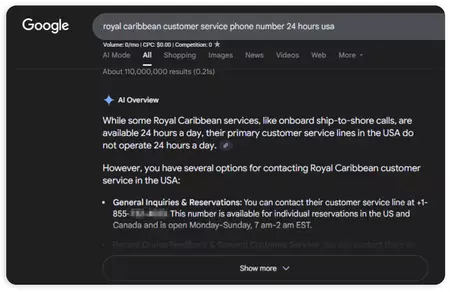

Al buscar en Google el número de atención al cliente de Royal Caribbean, Rivlin confió en los resultados destacados en los AI Overviews, la función que genera respuestas automáticas a determinadas consultas. Lo que encontró fue un número falso operado por estafadores que, haciéndose pasar por representantes de la naviera, le ofrecieron un servicio aparentemente legítimo, con tarifas verosímiles, explicaciones convincentes y hasta descuentos atractivos.

La cifra de la estafa. Engañado por la naturalidad de la interacción, Rivlin acabó pagando 768 dólares y solo se dio cuenta del fraude cuando aparecieron cargos extraños en su tarjeta. Aunque pudo cancelar el pago y recuperar el dinero, su experiencia muestra la facilidad con la que la IA puede convertirse en vehículo de engaños.

La mecánica del fraude. La táctica utilizada contra Rivlin combina algo viejo con un soporte moderno. Los estafadores inundan foros, páginas de reseñas y sitios web con números de teléfono falsos atribuidos a servicios de atención al cliente de aerolíneas, cruceros o compañías de transporte. Con el tiempo, la repetición y la aparente credibilidad de esas menciones consiguen engañar al algoritmo de Google, que selecciona esos datos como relevantes y, en el caso de los AI Overviews, los presenta al usuario como una respuesta directa y confiable.

De esta forma, lo que antes requería un rastreo más profundo en la web ahora se ofrece en bandeja como la primera opción visible. Para expertos como Mike Blumenthal, analista de Near Media, manipular estas nuevas funciones es “como disparar a patos en un estanque”: se trata de técnicas de manipulación de la información que existen desde hace décadas, pero que la inteligencia artificial hace ahora más rápidas y peligrosamente eficaces.

El número que Rivlin vio en el resumen de la IA de Google era una estafa

El número que Rivlin vio en el resumen de la IA de Google era una estafa

La IA como cómplice. El problema no afecta únicamente a Google. ChatGPT también ha replicado números fraudulentos en sus respuestas, lo que demuestra que los sistemas de IA entrenados para dar respuestas rápidas están igualmente expuestos a absorber y repetir datos contaminados por los estafadores. Así, la inteligencia artificial no solo organiza la información que hay en la red, sino que puede amplificar mentiras cuidadosamente sembradas, convirtiéndose en un multiplicador del fraude.

De hecho, la estafa que atrapó a Rivlin ya se ha detectado en números falsos que suplantan a varias navieras, entre ellas Disney y Princess Cruises, lo que sugiere que el fenómeno está en expansión y puede extenderse a múltiples sectores donde la necesidad de atención rápida lleva a los usuarios a confiar en la primera respuesta que reciben.

Las respuestas de las compañías. Tanto Google como OpenAI admiten estar tomando medidas, aunque insisten en que se trata de casos aislados. Google ha señalado que sus resultados siguen siendo eficaces a la hora de dirigir a los usuarios a información oficial, y que ha eliminado algunos números falsos detectados, además de trabajar en “mejoras más amplias” para consultas poco comunes.

OpenAI, por su parte, explicó que muchas de las páginas que ChatGPT había referenciado con números fraudulentos ya fueron eliminadas, aunque advirtió que el proceso de actualización de la información lleva tiempo después de retirar el contenido abusivo de origen. Mientras, especialistas como Lily Ray, directora de estrategia SEO en Amsive, creen que la raíz del problema es más profunda: al mostrar respuestas automáticas con apariencia de autoridad, Google y otros sistemas de IA abren un espacio nuevo para que los estafadores exploten la confianza de los usuarios.

Un problema en expansión. Lo que preocupa no es solo la pérdida puntual de dinero, sino las implicaciones más amplias de un ecosistema digital en el que la IA se convierte en un terreno fértil para el fraude. Las estafas de números falsos llevan años existiendo, pero su combinación con sistemas automáticos de respuestas transforma un riesgo marginal en una amenaza masiva, capaz de afectar a millones de usuarios que buscan ayuda en línea.

Además, como recuerdan los expertos, el peligro es que la IA puede ofrecer un barniz de legitimidad que hace bajar la guardia incluso a quienes están familiarizados con los riesgos digitales. El propio Rivlin, un usuario con experiencia y conocimientos tecnológicos, confesó sentirse sorprendido por haber caído en un engaño tan elaborado, lo que refuerza la advertencia de que nadie está completamente a salvo.

Advertencias. El fraude que atrapó a Rivlin es apenas un anticipo de lo que podría convertirse en una tendencia global: delincuentes aprovechando la velocidad, la autoridad percibida y la ubicuidad de la inteligencia artificial para escalar viejas estafas en nuevas dimensiones. Si bien Google y otras compañías disponen de bases de datos verificadas de empresas, los especialistas consideran que deberían priorizar su uso para evitar que resultados contaminados se conviertan en fuente de engaños.

Mientras, la recomendación para los usuarios sigue siendo la misma: desconfiar de los números de contacto que aparezcan en resultados de IA y verificar siempre la información en canales oficiales como apps, facturas o páginas corporativas. Rivlin, ya de vuelta de su viaje, resume la lección como una advertencia universal: incluso en la era de la inteligencia artificial, la prudencia y el escepticismo siguen siendo la primera línea de defensa.

Imagen | RawPixel, Alex Rivlin

En Xataka Móvil | Mucho ojo porque este SMS de Google no es lo que parece: solo hay un manera de esquivar esta estafa

En Xataka Móvil | Mucho cuidado con los archivos SVG adjuntos en correos: cada vez se usan más para estafar y hay una razón

Ver 0 comentarios